گجت نیوز نوشت: تکنولوژی دیپ فیک – deepfake مبنای ساخت بسیاری ویدیوهای تقلبی از چهرههای سرشناس است که با هدف گمراه کردن اذهان عمومی منتشر میشوند. آیا باید از سرعت سرسامآور پیشرفت این فناوری ترسید؟ در سال ۱۹۱۷، کمی پس از اختراع دوربینهای شخصی، تصاویری تکاندهنده از کودکانی که در کنار ارواح یا موجودات اساطیری […]

گجت نیوز نوشت: تکنولوژی دیپ فیک – deepfake مبنای ساخت بسیاری ویدیوهای تقلبی از چهرههای سرشناس است که با هدف گمراه کردن اذهان عمومی منتشر میشوند. آیا باید از سرعت سرسامآور پیشرفت این فناوری ترسید؟

در سال ۱۹۱۷، کمی پس از اختراع دوربینهای شخصی، تصاویری تکاندهنده از کودکانی که در کنار ارواح یا موجودات اساطیری قرار داشتند، در سرتاسر دنیا منتشر شدند! صحت این تصاویر توسط تعدادی از متخصصین آن زمان تایید شدند و آرتور کونان دویل، نویسنده سرشناس رمانهای علمی تخیلی و معمایی هم به گسترش مفاهیم برگرفته از این تصاویر کمک کرد.

چندین دهه بعد، کودکان حاضر در این تصاویر که به افرادی میانسال تبدیل شده بودند تایید کردند که این تصاویر تماما ساختگی بوده و با سرهم کردن قطعات مختلف کاغذ ساخته شده بودند. بنابراین تاریخچه انتشار تصاویر تقلبی با هدف سرگرمی، کلاهبرداری یا ترساندن افراد، قدمتی به اندازه دوربینهای همراه دارد!

در تمام این سالها میل انسان به ساخت تصاویر مختلف با بهرهگیری از تخیل و تصوراتش، زمینهساز سرگرمیهایی مهم بوده که صنعت فیلم و سینما با استفاده از ادوات سختافزاری، حقههای تصویربرداری یا ویرایشهای پس از تولید اقدام به ساخت این دسته تصاویر نموده است.

با پیشرفت تکنولوژیهای تصویربرداری و دیجیتالیتر شدن آنها، روشهای جدیدی برای ساخت تصاویر غیرواقعی در اختیار عموم مردم قرار گرفت. در عین حال، گسترش این تکنولوژیها چندان هم بیخطر نبود و به تدریج نگرانیهایی را در میان مردم ایجاد کرد.

امروزه، هر کسی با اندکی مهارت و دسترسی به نرم افزارهای مربوطه قادر است تصاویر و ویدیوهایی ساختگی از هر فرد دیگری را تولید کرده و منتشر کند. در این شرایط چگونه میتوانیم به چشمانمان اعتماد کنیم و از صحت اخبار و یا ویدیوهایی که در اینترنت یا سایر بسترهای مجازی میبینیم مطمئن باشیم؟

تکنولوژی دیپ فیک چیست؟

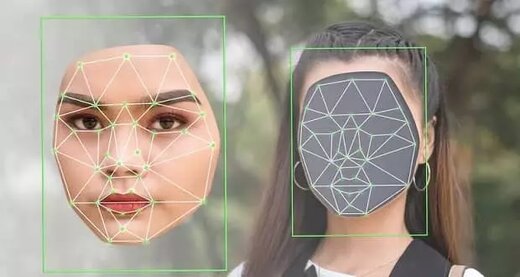

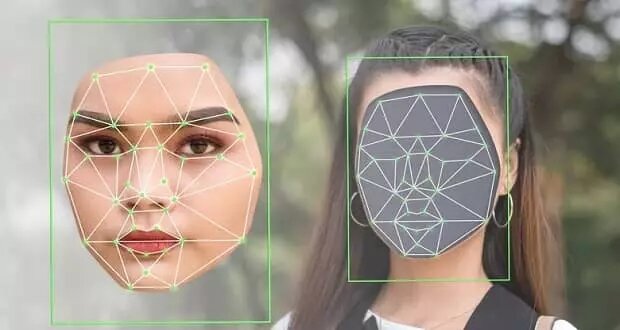

عبارت دیپ فیک (deep fake) امروزه عملا برای هر گونه تصویر ساختگی از افراد استفاده میشود. اما این نامگذاری درست نیست و دیپ فیک تعریفی مشخص دارد. برای این که تصویری ساختگی در دسته دیپ فیک قرار گیرد باید شرایط خاصی داشته باشد. به عنوان مثال، محتوای مورد نظر باید حتما یک ویدیو باشد و همچنین از هوش مصنوعی برای ساخت آن استفاده شده باشد. عبارت deep (عمیق) در کلمه deep fake به الگوریتمهای یادگیری عمیق به کار رفته در ساخت تصاویر دستکاری شده به کمک این تکنولوژی اشاره دارد.

به بیان دقیقتر، هر ویدیویی که به کمک یک یا چند الگوریتم هوش مصنوعی ساخته شده و تصاویری باورپذیر که در واقعیت رخ ندادهاند را نمایش دهد، در دسته ویدیوهای دیپ فیک قرار میگیرد.

به کمک هوش مصنوعی میتوان تمامی صندلیهای درون یک ویدیو را با پرتقالهای غولپیکر جایگزین کرد یا با کمی خلاقیت دست به انجام کارهایی باورنکردنی زد. بنابراین کاربرد هوش مصنوعی در ساخت ویدیوهای دستکاریشده بسیار گسترده است. با این وجود، تکنولوژی دیپ فیک عموما با چهرهها سر و کار داشته و بیش از هرکس، چهرههای مشهوری نظیر سلبریتیها یا سیاستمداران را شامل میشود.

از یک منظر خاص، همه ما به طور روزانه با دیپ فیک سر و کار داریم و ویدیوهای سادهای را با بهرهگیری از این تکنولوژی میسازیم. بنا به گزارش Forbes، فیلترهای مورد استفاده در اسنپ چت یا تیک تاک به نحوی از قابلیت تشخیص چهره بهره میبرند و با استفاده از هوش مصنوعی چهره کاربر را تغییر داده یا جزئیاتی را به آن اضافه میکنند.

نخستین شبکه تهاجمی مولد

انواع مختلفی از هوش مصنوعی وجود دارد که هریک قابلیت منحصربفردی دارند. برخی از این هوشهای مصنوعی در تشخیص صدا و ارائه پاسخ به آن تخصص دارند و برخی دیگر محیط را شناسایی کرده و در داخل آن به جستجو میپردازند.

این دسته هوشهای مصنوعی عموما بر پایه علوم یا مستندات کنونی انسان استوار هستند و صرفا قادر به تقلید از رفتار انسان در یک شرایط خاص میباشند. از سوی دیگر، گام بعدی برای این تکنولوژی خلق پدیدههای جدید است.

در سال ۲۰۱۴، یان گودفلو و همکارانش چارچوب جدیدی را برای تمرین دادن هوش مصنوعی مولد ارائه کردند. این سیستم که با نام شبکه تهاجمی مولد شناخته شد، برای نخستین بار بر روی پایگاه Arxiv قرار گرفت. ایده شبکه عصبی آنها کاملا خلاقانه بود و بر پایه مقایسه دو مدل کامپیوتری با هم بنا شده بود. مدل اول، هرچه کاربر میخواست، اعم از حروف، اعداد و یا حتی چهره افراد را تولید میکرد و سیستم دوم تعیین میکرد که آیا دادههای تولید شده توسط کامپیوتر اول منحصربفرد هستند یا برگرفته از دادههای واقعی مورد استفاده برای تمرین دادن الگوریتم!

در صورتی که سیستم دوم تشخیص میداد که مدل تولید شده توسط کامپیوتر اول منحصربفرد است، این مدل در بخشی جداگانه ذخیره میشد و چرخه مجددا به جریان میافتاد. ماهیت مقایسهای این روش باعث درگیری دائم سیستمهای اول و دوم با یکدیگر و در نتیجه تولید تصاویر تصاویر غیرواقعی قانعکنندهتری میشد.

توانایی تمرین دادن الگوریتمهای هوش مصنوعی با تصاویر واقعی با هدف دست یافتن به چهرههای تقلبی، پایه و اساس تکنولوژی دیپ فیک را تشکیل میدهد.

جوانسازی و تغییر چهره در فیلمهای سینمایی

حوالی زمانی که گودفلو در حال معرفی نخستین شبکه تهاجمی مولد خود بود، استودیو لوکاس فیلم با جدیت کار بر روی فیلم Rogue One، نخستین فیلم ساخته شده از دنیای جنگ ستارگان که مستقیما به خاندان اسکایواکر مرتبط نبود را پیگیری میکرد. در این فیلم، دو کاراکتر نام آشنای نسخههای پیشین این مجموعه، یعنی گرند مف تارکین و شاهزاده لیا در فیلم حضور داشتند. این در حالی بود که هیچ یک از دو بازیگر ایفاگر این دو نقش، پیتر کوشینگ و کری فیشر، قادر به ایفای نقش در فیلم نبودند!

در عوض، سازندگان فیلم از بازیگران دیگری به جای این کاراکترها استفاده کرده و پس از ضبط، با استفاده از هوش مصنوعی، چهره پیتر کوشینگ و کری فیشر جوانتر را جایگزین این بازیگران کردند. البته در این میان لازم بود که بازیگران انتخابشده علاوه بر طراحی کلی صورت، در لحن ادای دیالوگها نیز شبیه به فیشر و کوشینگ باشند.

در سالهای بعد فیلمسازان رو به استفاده از تکنولوژی موشن کپچر آوردند که از نقطههایی روی صورت بازیگران برای شناسایی حرکات بهره میبرد. پس از اتمام ضبط، فیلمسازان دادههای موجود از موشن کپچر را مورد استفاده قرار داده و افکتهای مختلفی را بر روی آن اعمال میکردند.

به این ترتیب، با این که در زمان انتشار فیلم Rogue One هنوز تکنولوژی دیپ فیک مانند امروز فراگیر نشده بود، اما بسیاری از افراد به واسطه این فیلم با پیشرفتهای تکنولوژیکی که در شرف رخ دادن در صنعت فیلمسازی بود، آشنا شدند.

ریشه عبارت دیپ فیک

در ادبیات امروزی، عبارت دیپ فیک مفهوم بسیار جامعی پیدا کرده و برخی از ما بدون توجه به ریشه این عبارت، از آن در شرایط مختلف استفاده میکنیم. با این وجود، نامگذاری این عبارت هوشمندانهتر از چیزی که به نظر میرسد، انجام شده است! کلمه دیپ فیک (Deep fake) در حقیقت تشکیل شده از دو کلمه دیپ به معنای عمیق و فیک به معنای قلابی است. کلمه عمیق در این عبارت، همان طور که اشاره شد، به الگوریتمهای یادگیری عمیق اشاره دارد و فیک هم حاکی از قلابی بودن تصاویر ایجاد شده است.

ادوبی به شما امکان میدهد هر عبارتی که مایلید را بخوانید

در سال ۲۰۱۶ ادوبی نرم افزاری تحت نام VoCo را رونمایی کرد که قرار بود همان نقشی را برای فایلهای صوتی ایفا کند که فوتوشاپ برای تصاویر انجام میداد! این نرم افزار به تنها ۲۰ دقیقه از صدای یک فرد نیاز داشت تا بتواند مدلی از صدای او را بازسازی کند.

به طور کلی چهرههای شناختهشده نظیر سیاستمداران ساعتها ترک صوتی، مصاحبه و اجراهای زنده را در آرشیوهای مختلف صوتی و ویدیویی دارند. همچنین در سالهای اخیر پادکستها هم منابع خوبی برای جمعآوری فایلهای صوتی به شمار میروند؛ به طوری که جمعآوری یک ترک صوتی ۲۰ دقیقهای کار چندان سختی نیست! حتی با نگاهی به اپلیکیشنهای پیامرسان در گوشی خودمان نیز میتوانیم ترکهای صوتی فراوانی پیدا کنیم که مجموع آنها قطعا بیش از بیست دقیقه خواهند بود.

در گام بعدی، اپلیکیشن VoCo میتواند با آنالیز همین ترک بیست دقیقهای، مدلی را طراحی کند که دقیقا مانند صدای هدف صحبت میکند و هرچه را که تایپ کنیم به زبان میآورد. ادوبی برای نمایش توانایی این نرم افزار، مصاحبهای از بازیگر هالیوودی، کیگان مایکل را پخش کرده و سپس بخشهای مختلفی از جملات ادا شده توسط او را جابجا میکند. همچنین در گام نهایی، ادوبی بخش از سخنرانی او را کاملا حذف کرده و با بخش دیگری جایگزین میکند.

نتیجه کار، فایلی صوتی تشکیل شده از جملات، عبارات و کلماتی است که گوینده اصلی هرگز به زبان نیاورده است! البته ادوبی فکر سوء استفادههای احتمالی از این تکنولوژی را هم کرده و فایلهای صوتی تولید شده توسط VoCo را به طور خاصی نشانهگذاری میکند تا تشخیص تقلبی بودن آن ممکن باشد!

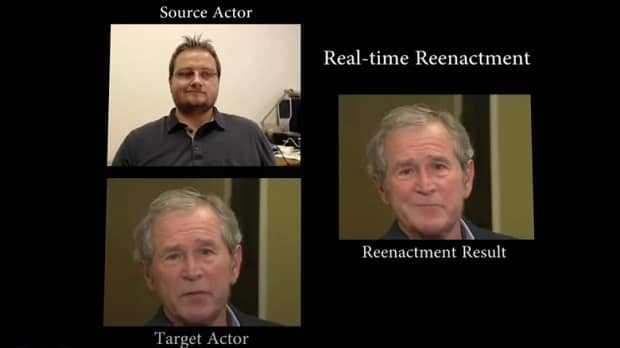

Face2Face؛ دیگر قابلیت باورنکردنی تکنولوژی دیپ فیک

در سال ۲۰۱۸ دانشمندانی آلمانی و آمریکایی برای نخستین بار Face2Face را در مقالهای که در مجله علمی Communications of the ACM چاپ شد، معرفی کردند. در این مقاله دانشمندان یاد شده به توضیح در خصوص فرآیند استفاده از حرکات چهره به منظور دستکاری حالت چهره یا حرکت دهان در ویدیوهای مختلف پرداختند.

Face2Face برای انجام این کار از دو دسته ویدیو استفاده میکند. دسته اول، ویدیویی است که قصد اعمال تغییرات در آن را دارید و دسته دوم، ویدیوهایی از بازیگری است که تغییرات مد نظرتان را بازی میکند. به ادعای نویسندگان، ویدیوی هدف میتواند از هر منبعی مانند یوتیوب استخراج شده باشد؛ در حالی که ویدیوی دوم حتی میتواند توسط وبکم ضبط شود!

پس از این که ویدیوی دوم به عنوان ورودی در اختیار الگوریتم Face2Face قرار گرفت، سیستم، حرکات چهره آن را اسکن کرده و تغییرات چهرههای آن را به ویدیوی اصلی منتقل میکند. در صورتی که بازیگر قادر باشد صدای کاراکتر هدف را نیز به خوبی تقلید کند، نتیجه کار فوقالعاده خواهد بود؛ هرچند که این کار به طور خاص ضرورتی ندارد.

بنابراین با استفاده همزمان از Face2Face و Voco ادوبی میتوان علاوه بر این که صدای شخصیت هدف را به طور دقیق شبیهسازی کرد، کنترل چهره و علائم صورت او را نیز به طور کامل به دست گرفته و یک ویدیوی تقلبی کاملا باورپذیر از او را تولید کرد.

DeepFaceLive

ساخت ویدیوهای دیپ فیک اساسا بر پایه استفاده از ویدیوهایی در دسترس و دستکاری آنها از طریق الگوریتمهای هوش مصنوعی استوار است. چندی پیش، کاربری از تیک تاک که پیش از این وظیفه ساخت ویدیوهایی تقلبی از تام کروز را بر عهده داشت، در مصاحبهای با Today اعلام کرد که پیش از این ساخت یک کلیپ دیپ فیک برای تیک تاک چندین هفته یا بیشتر زمان میبرد.

با این حال، با گذشت حدود یک سال از این مصاحبه، ساخت ویدیو با استفاده تکنولوژی دیپ فیک تنها چند روز زمان نیاز دارد. با پیشرفت تکنولوژیهای حوزه هوش مصنوعی، زمان ساخت ویدیوهای دیپ فیک نیز کاهش یافته و استفاده از آن در دسترس افراد بیشتری قرار میگیرد. یکی از مصادیق این امر، توسعه ابزار DeepFaceLive است.

DeepFaceLive یک ابزار اوپن سورس است که در سال ۲۰۲۱ توسط توسعهدهندهای روسی به نام Iperov ساخته شده و در گیتهاب قرار گرفت. سازنده DeepFaceLive پیش از آن در توسعه فناوری دیپ فیک تاثیر بسزایی داشته است. به گزارش Daily Dot این ابزار نیز همانند دیگر نرم افزارها و سرویسهای این حوزه، از تمرین دادن الگوریتمهای AI برای شبیهسازی صدا و چهره شخصیتها استفاده میکند؛ با این تفاوت که در این اپلیکیشن، فرآیندهای یاد شده به صورت ریلتایم انجام میشود.

تکنولوژی مورد استفاده در DeepFaceLive بسیار شبیه به فیلترهاییست که در اسنپ چت یا تیک تاک استفاده میشود. با این وجود، به جای تبدیل کردن چهره افراد به سگ یا دیگر حیوانات، میتوانید چهرهتان را به یک سلبریتی تبدیل کنید. این ابزار همچنین با اکثر نرم افزارهای تماس ویدیویی نظیر زوم یا اسکایپ سازگار بوده و عملا به کاربران این امکان را میدهد که در نقش شخصیت دیگری در تماس ویدیویی حاضر شوند!

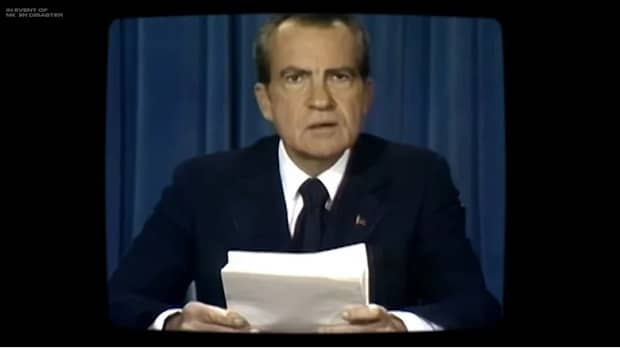

ماجرای In Event of Moon Disaster

همان طور که اشاره شد، از زمان توسعه تکنولوژی دیپ فیک، یکی از نگرانیهای اصلی مربوط به احتمال استفاده از این ویدیوهای تقلبی و باورپذیر در رویدادهای مختلف با هدف فریب دادن مخاطبان بوده است. با این وجود، برخی استفادههای این ابزارها که عموما با هدفهای سرگرمی یا آموزشی هستند، مفید بوده و کاربردهای زیادی دارند.

یکی از نشانههای این امر در زمان پرتاب سفینه آپولو ۱۱ اتفاق افتاد؛ جایی که نیل آرمسترانگ، باز آلدرین و مایکل کالینز به سفری اسرارآمیز به کره ماه فرستاده شدند. در آن زمان، دولتمردان ایالات متحده آماده دو نتیجه مختلف از این پروژه بودند.

از یک طرف، ریچارد نیکسون، رییس جمهور وقت ایالات متحده آمریکا در یک سخنرانی، از پرتاب موفقیتآمیز این سفینه خبر داد و فرود نخستین انسانها بر روی کره ماه را تبریک گفت. از سوی دیگر، سالها بعد، یک ویدیوی کاملا متفاوت از نیکسون ساخته شد که در آن، خبر از شکست پروژه و تراژدی رخ داده در فاصلهای بسیار دور از زمین داده میشد!

ویدیوی دوم، یک ویدیوی کاملا تقلبی بود که سازندگان با هدف آمادهسازی اذهان جامعه در صورت شکست پروژه آپولو ۱۱ آماده کرده بودند. برای ساخت این ویدیوی هشت دقیقهای، یک بازیگر، جملاتی که ریچارد نیکسون هرگز ادا نکرده بود را با لحنی شبیه به او قرائت کرد و سپس تکنولوژیهای هوش مصنوعی برای دستکاری صدا و تصویر این ویدیو به گونهای مورد استفاده قرار گرفتند که انگار نیکسون واقعا در حال قرائت آن متن بود.

تکنولوژی دیپ فیک با سرعت سرسامآوری در حال پیشرفت است

مدتی پیش، ویدیوهای دیپ فیک صرفا پدیدههایی جذاب بودند که برای مصارف سرگرمی مورد استفاده قرار میگرفتند؛ چرا که آینده آنها ترسناک به نظر میرسید و جوامع مختلف نسبت به استفاده واقعی از این فناوریهای خوشبین نبودند.

با این حال با پیشرفت فناوریهای این حوزه و در دسترس قرار گرفتن هرچه بیشتر ابزارهای مرتبط با این تکنولوژی، تعداد ویدیوهای دیپ فیک با نرخی انفجاری رو به افزایش رفت؛ به طوری که بر اساس گزارش موسسه Sensity که میزان گسترش تکنولوژی دیپ فیک را از سال ۲۰۱۸ تحت نظر دارد، تعداد این ویدیوها هر شش ماه تقریبا دو برابر میشود.

البته تنها بخش کوچکی از این ویدیوها با هدفهای سرگرمی ساخته شدهاند و گسترش این ویدیو در زمینههای غیراخلاقی و مخرب به طرز چشمگیری سریعتر بوده است.

همچنین سرعت فراگیری دیپ فیک در سایر زمینههای تکنولوژیک آهستهتر است؛ به طوری که در این زمینهها شاهد دو برابر شدن تعداد این ویدیوها هر دو سال یک بار هستیم. با این وجود تقریبا همه صاحبنظران عقیده دارند که زمانی فرا خواهد رسید که تشخیص ویدیوهای واقعی از تقلبی بسیار دشوار خواهد بود.

اوضاع آنچنان که به نظر میرسد آشفته نیست!

در حال حاضر تمرکز فناوری Deepfake بیشتر بر روی شخصیتهای سیاسی و سلبریتیها معطوف است. بنابراین، علیرغم این که توسعه این تکنولوژی باعث کمرنگتر شدن مرزهای واقعیت و تجسم شده است، اما احتمال این که یک فرد معمولی سوژه دیپ فیکهای مخرب قرار گیرد، پایین است. البته این امر قطعا در آینده دستخوش تغییر خواهد شد و جامعه گستردهتری از افراد جامعه هدف این فناوری قرار خواهند گرفت.

البته باید به این امر هم اشاره کنیم که علیرغم پیشرفتهای انجام شده در این حوزه، دانشمندان همچنین به دستاوردهای مهمی در زمینه تشخیص ویدیوهای دیپ فیک دست یافتهاند. به گزارش PNAS در حال حاضر، تکنولوژیهای سرآمد تشخیص ویدیوهای دیپ فیک قادرند ویدیوهای تقلبی را با دقت ۶۵ درصد تشخیص دهند. به طور کلی، توانایی تشخیص چشم انسانها در خصوص دیپ فیک بهتر از تکنولوژی عمل میکند. با این وجود به نظر میرسد علم در حال کم کردن فاصله در این زمینه است.

به تازگی محققین دانشگاه ریورساید کالیفرنیا موفق به توسعه روشی شدهاند که ویدیوهای دیپ فیک را با دقت ۹۹ درصد شناسایی میکند. این متد قادر است علاوه بر شناسایی تغییر کلی چهره، تغییر حالات چهره را هم پیشبینی کند. علاوه بر این، تکنولوژی مورد بحث همچنین قادر است به طور دقیق تشخیص دهد کدام بخش از چهره دستخوش تغییر شده است!

با وجود این پیشرفت بزرگ تکنولوژیک، در حال حاضر هنوز امکان تشخیص ویدیوهای تقلبی دیپ فیک بدون در اختیار داشتن ابزارهای مناسب فراهم نیست. بنابراین لازم است مواظب باشیم در دام سودجویان احتمالی نیفتیم.

نظر شما در خصوص فناوری دیپ فیک چیست؟ آیا شما هم نسبت به آینده این تکنولوژی تردید و ترس دارید یا آن را به عنوان یک ابزار جذاب و کاربردی پذیرفتهاید؟

۲۲۷۲۲۷

Tuesday, 26 November , 2024